Come fare un A/B test: la guida completa

È difficile parlare di ottimizzazione di un sito internet senza menzionare gli A/B test, o split test. La ragione è che un A/B test è il sistema più semplice, immediato e sicuro per ottimizzare la propria attività online in maniera scientifica, senza doversi affidare al caso e incrociare le dita.

In questo articolo, ti spiego come fare un A/B test perfetto. Anche se adesso non sai nemmeno cosa siano, alla fine di questo articolo saprai tutti i passi per completarne uno e migliorare la tua attività online.

Cos’è un A/B test

Il concetto di A/B test non è niente di nuovo, e si utilizza nel business da decenni prima di internet: si tratta di un confronto fra due varianti, per stabilire quale sia la migliore. Oggi parleremo solo degli A/B test online, quelli che ci interessano.

Nella variante classica, si divide in maniera casuale il traffico sul proprio sito web in due: metà vanno su una pagina, metà su un’altra. Queste due pagine sono quasi identiche, tranne che per un elemento scelto come oggetto del test. Si traccia poi il tasso di “conversione” di quelle pagine, per stabilire quale sia la versione migliore.

“Conversione” è fra virgolette, perché esistono diversi tipi di conversione. Ad esempio:

- Acquisto o opt-in per un prodotto.

- Tempo di permanenza sul sito.

- Tempo di visualizzazione di un video.

- Bounce rate.

- Return rate.

- Importo totale dell’ordine su un e-commerce.

E via di questo passo.

Insomma, una conversione può essere qualsiasi risultato misurabile. In questo articolo con conversione intendiamo un acquisto o opt-in: è il più semplice da capire, soprattutto quando si parla di formule matematiche.

Un esempio di A/B test

Ho una pagina di vendita del mio prodotto. Quella pagina espone tutti i benefici del prodotto, e alla fine, c’è un grosso bottone con scritto “clicca qui per acquistare ora”.

Ma non sono sicuro che quello sia il bottone migliore da usare. Invece, voglio provare a scrivere “clicca qui per entrare nel portale”. Quindi creo una seconda pagina distinta, dove il testo sul bottone è l’unica differenza. Per il resto, le pagine sono uguali.

Poi tramite un software apposito mando metà del traffico sulla pagina originale, e metà sulla nuova pagina con il nuovo testo.

Se dopo quattro settimane di test la pagina originale ha un tasso di conversione (acquisto del prodotto) del 3%, e quella nuova del 4% posso dire, dati alla mano, che la seconda pagina è migliore della prima. Visto che il testo sul bottone è l’unica cosa che ho cambiato, allora il nuovo testo dev’essere più efficace del primo.

Posso a questo punto sostituire il vecchio testo con quello nuovo, e godere di un maggior tasso di conversione da qui in avanti.

Questa è la base di un A/B test, ma da qui in avanti le cose si complicano. La maggior parte delle persone fa errori che rendono i risultati inutili.

Ma non temere: in questo articolo, ti spiegherò tutto quello che devi tenere in considerazione quando crei un test. A partire dall’intervallo di confidenza (di cui parlo più avanti), l’errore più grande che viene commesso negli A/B test.

Algoritmo bayesiano contro frequentista

Negli ultimi mesi, si sta accendendo la diatriba “è meglio un algoritmo bayesiano o frequentista?”

Non voglio dedicare troppo tempo a questo argomento, visto che si scende veramente nel tecnico. Ma un’indicazione mi pare necessaria.

In sostanza, per gli A/B test, bayesiano o frequentista non cambia niente. L’algoritmo frequentista è più semplice, il bayesiano più completo in certi aspetti. Ma per il tipo di test di cui ci occupiamo in questo articolo, tutti e due forniscono lo stesso identico risultato.

Quindi, se sei indeciso fra due software, e uno si vanta di usare un “avanzato algoritmo bayesiano”, non ascoltarli: per quello che interessa a noi, non cambia niente.

Test multivariati

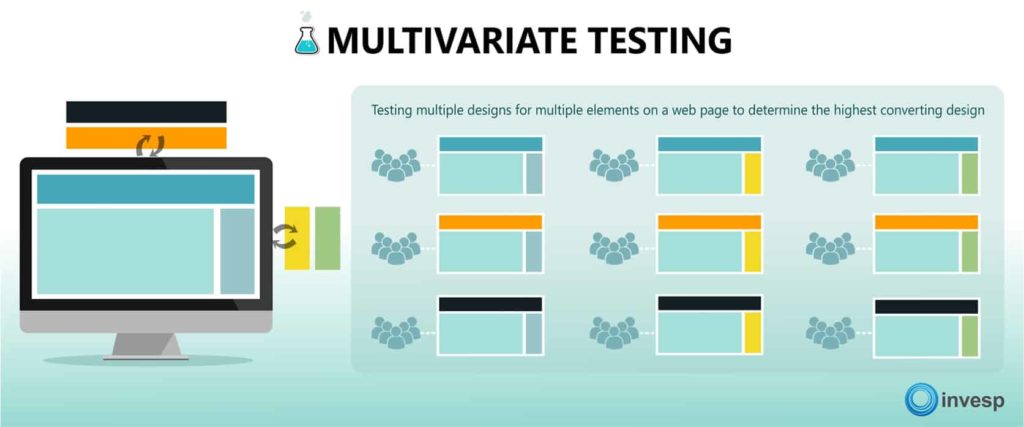

Il test di tipo A/B è il più comune, ma esiste anche un altro tipo di split test: il test multivariato.

Questo è un tipo di test che mette insieme diversi test A/B.

Ad esempio ho 3 titoli diversi, e voglio capire quale sia il migliore da usare sulla mia pagina di vendita. Ma allo stesso tempo ho anche 3 immagini diverse del prodotto, che voglio testare.

Invece di fare due test A/B diversi, posso fare un unico test multivariato in cui verranno testate insieme tutte le combinazioni possibili fra i 3 titoli, e le 3 immagini prodotto.

Quindi il mio test avrà in totale 9 varianti distinte, ossia 3×3. Se ho anche 2 bottoni diversi da testare, il totale delle varianti sarà 3x3x2 = 18 varianti.

Il vantaggio del test multivariato, rispetto all’A/B, è che testa anche l’interazione fra i vari elementi. Ma per rendere un test multivariato statisticamente significativo servono quantità astronomiche di traffico, per questo non me ne occuperò oggi.

Test A/B/n

Finora ho parlato di test A/B, ma il termine corretto sarebbe test A/B/n.

Questo perché non sono obbligato a testare solo 2 varianti alla volta. Ne posso testare tre, quattro, cinque, cento tutte insieme. Non c’è un limite tecnico alle varianti che posso aggiungere, solo pratico.

Infatti, per ogni variante che viene aggiunta, vanno ad aumentare:

- La quantità di traffico necessaria per rendere il test significativo.

- Di conseguenza, il tempo necessario per svolgerlo.

Per questo, se il traffico è poco, è meglio fare solo test A/B. Col crescere del traffico, si possono aggiungere varianti per gli A/B/n test successivi.

Test quantitativi e qualitativi

Sia gli A/B test che i test multivariati, sono test quantitativi. Significa che il risultato sarà un numero, o una serie di numeri.

Questi test sono importanti, ma non dobbiamo dimenticarci anche dei test qualitativi: fare delle domande aperte ai propri utenti.

Ad esempio, quando una persona ha comprato il prodotto, si può chiedere perché hanno scelto di acquistare proprio oggi. Oppure, se c’è stata qualche difficoltà nel processo di pagamento.

Queste risposte non vanno a fornire numeri, ma servono a capire i propri utenti e ricevere feedback. In altre parole: gli A/B test dicono il cosa e il come, ma i test qualitativi dicono il perché succede qualcosa.

I due tipi di test si completano a vicenda, e dovresti condurli entrambi per avere una panoramica completa sul tuo business.

Una cosa che piace fare a me è utilizzare una campagna email, ogni qualche settimana o mese, per chiedere un feedback agli utenti. L’argomento varia, ma ogni volta raccolgo risposte preziose.

Poi uso le risposte del mio test qualitativo (feedback) per ideare nuovi A/B test.

I 4 principi degli A/B test

Ora abbiamo capito cos’è un A/B test e come funziona. Il passo successivo, prima di parlare di come svolgerne uno, è di capire i 4 principi fondamentali.

Questi sono i principi che devi sempre tenere a mente quando fai un A/B test. Dimenticatene uno, e il tuo test sarà invalido.

1 – Elimina tutte le variabili esterne

In laboratorio, è facile creare un A/B test perfetto. Le condizioni sono, per definizione, controllate. Posso modificare una variabile, e osservare come influisce sul risultato.

Ma nella realtà, isolare una sola variabile è impossibile. Ecco alcune variabili esterne che possono rendere invalido il tuo A/B test:

- Giorno della settimana, mese o stagione.

- Meteo e condizioni climatiche.

- Eventuali festività.

- Fonti di traffico

- Demografia (età, uomo/donna, lavoro…)

Quando facciamo un A/B test possiamo provare a minimizzare le variabili, ma non annullarle. Anche per questo serve un campione molto elevato, ossia fare test su tantissime persone. Più è elevato il campione, più c’è possibilità che le variabili casuali si annullino a vicenda.

Per questo non ha senso fare A/B test per calcolare la deliverability degli autoresponder: le variabili in gioco sono talmente tante, che è impossibile fare un test puro.

Tuttavia, ci sono alcuni principi che vanno seguiti per minimizzare le variabili esterne. Andiamo a vederli.

Testa le varianti simultaneamente

Per eliminare tutte le variabili riguardanti il tempo, le versioni vanno testate simultaneamente.

Non si può guardare il tasso di conversione per un mese, poi modificare la pagina, e vedere se nel mese successivo ci sono delle modifiche. Il test non è valido, perché a seconda del mese e della stagione il tasso di conversione varia.

Bisogna usare un programma apposito, che divide il traffico in tempo reale fra due varianti. Parlerò di questi software in fondo all’articolo.

Usa una sola fonte di traffico

Il traffico diretto è molto diverso dal traffico di Facebook, e quello organico è ancora una storia a sé. Per questo, fonti di traffico diverso potrebbero convertire meglio con pagine diverse.

Questa è una variabile che non viene quasi mai presa in considerazione, e un A/B test viene fatto ignorando la provenienza del proprio traffico. Entro un certo limite questo può andar bene, perché la variabile tende ad annullarsi da sola, ma vengono perse molte opportunità.

Ad esempio, con due varianti A e B, il traffico organico può convertire meglio con A, mentre quello Facebook con B. L’ideale è fare due A/B test, uno per Google e uno per Facebook, e separare i risultati.

Il problema di questo approccio è che allunga e complica i test.

Li allunga, perché devo aspettare più tempo per avere un dato statisticamente significativo. E li complica, perché devo usare due URL diversi per il traffico proveniente da fonti diverse. Esistono software che lo fanno in maniera automatica, ma è sempre una complicazione in più.

Il mio consiglio è, se sei all’inizio, di non considerare questo fattore. Ma appena ricevi ingente traffico da fonti diverse, considera la possibilità di fare A/B test specifici per ognuna.

2 – Testa un solo elemento alla volta

L’idea, quando fai un A/B test, è di imparare una lezione. Idealmente, devi essere sempre in grado di capire qual è stata la variabile che ha influenzato la conversione.

Quindi, se faccio un A/B test e modifico sia il titolo che l’immagine prodotto, alla fine non saprò quale dei due ha migliorato la conversione. Per questo devi testare sempre un singolo elemento alla volta: fai più A/B test per vari elementi, così da poter ottimizzare la pagina un po’ alla volta.

Non farti prendere dalla foga di cambiare tutto insieme: a meno che tu non abbia la mole di traffico necessaria per un test multivariato, fare A/B test per migliorare una pagina è un procedimento che richiede tempo.

L’eccezione: A/B test di una pagina intera

C’è un’eccezione alla regola qui sopra, quando vuoi cambiare completamente una pagina.

Gli A/B test in genere vengono utilizzati per modifiche incrementali: modifico un elemento, vedo se funziona meglio, poi passo al prossimo elemento. Funziona, ma ci sono due problemi:

- Serve tanto, tanto tempo a cambiare molti elementi.

- Non posso testare una pagina radicalmente diversa.

Ad esempio, voglio provare a cambiare la mia pagina di vendita: togliere tutto il testo, e sostituirlo con un video. Oppure, voglio testare un nuovo approccio: fare leva su una caratteristica del prodotto, invece che un’altra. In tutti questi casi, non posso isolare un singolo elemento. Queste sono modifiche che interessano tutta la pagina.

Nessun problema, posso fare un test sull’intera pagina: cambio tutto quello che devo cambiare, e faccio partire il test.

Nota che qui non sto testando un solo elemento, ma sto testando comunque una sola ipotesi. Nello specifico:

- Converte di più il formato testo, o il formato video?

- È meglio sottolineare questa o quella caratteristica del prodotto?

L’idea è che un A/B test deve rispondere a una domanda specifica, detta ipotesi: è meglio X o Y? Finché il test saprà rispondere a questa domanda con un risultato statisticamente valido, allora è un buon A/B test.

3 – Usa dati statisticamente significativi

Questa è la bestia nera di chi è alle prime armi con gli A/B test.

Un errore comune è concluderlo prima di aver raggiunto un risultato statisticamente significativo: se faccio fare il mio A/B test a 10 persone, a questo punto tanto vale tirare una monetina!

In questo capitolo andremo a parlare di matematica, ci saranno tanti numeri e concetti un po’ più difficili da digerire. Ma se vuoi fare dei veri A/B test, devi assolutamente conoscerli. Per questo ti consiglio di leggere la parte che segue più volte, finché non l’hai bene interiorizzata.

Perché se non prendi ogni precauzione per far sì che i dati siano statisticamente significativi, non lo saranno. E allora il tuo A/B test sarà inutile. O peggio, potrà essere dannoso per il tuo tasso di conversione!

L’importanza dell’intervallo di confidenza

Diciamo che mando 100 visitatori sulla mia pagina, di questi 100 visitatori, 5 acquistano il prodotto. Quindi ho un tasso di conversione del 5% sulla mia pagina, giusto?

Sbagliato, purtroppo. Il tasso di conversione è probabilmente da qualche parte fra 1,032% e 8,968%.

Spiegare il motivo di ciò in maniera precisa è complicato, e include un viaggio fra deviazione standard, mediana della popolazione, z-score, scarto quadratico, e tanti altri termini che vanno ben al di là dello scopo di questo articolo. Ma per riassumere:

Non si può mai essere certi di un risultato, ma si può calcolare entro che raggio, probabilmente, si attesta la conversione. Più conversioni ho, più sarà precisa la mia predizione.

Lo spiego in parole più semplici.

Ho il primo visitatore sulla mia pagina, e non converte (acquista). 0 acquisti su 1 visitatore, è un tasso di conversione dello 0%. Arriva il secondo visitatore, nemmeno lui acquista, tasso di conversione dello 0%. Il terzo visitatore acquista, quindi 1 acquirente su 3, tasso di conversione del 33,3%.

Se fermassi qui il mio A/B test, potrei concludere che la mia pagina converte al 33%. Ma se faccio andare avanti il mio test fino ad avere 100 visitatori, mi accorgo che non è così: trovo un tasso di conversione del 5%, quindi 5 persone su 100 hanno acquistato.

Più è numeroso il campione, ossia più persone faccio entrare nel mio A/B test, più sarò certo del risultato. Insomma, se ci sono 50.000 persone che hanno fatto l’A/B test, posso essere abbastanza sicuro dei risultati che ottengo.

Questo concetto viene riassunto nell’intervallo di confidenza. Nessun numero è preciso, c’è sempre un po’ di incertezza. Più aumentano le persone che fanno l’A/B test, più l’incertezza si riduce.

Quindi, se il mio A/B test è fatto da 50.000 persone, magari so che il mio tasso di conversione è fra 4,99% e 5,01%: un numero molto più preciso, sul quale posso estrapolare dati statisticamente significativi.

Se concludo un A/B test prima di raggiungere un alto intervallo di confidenza, a questo punto faccio prima a tirare una monetina per stabilire il vincitore.

Quindi la domanda è: quanto deve andare avanti uno split test prima di essere statisticamente significativo? Andiamo a vedere.

Certezza statistica

Quello che interessa a noi, quando facciamo un A/B test, è sapere se la variante B è superiore alla A o viceversa, con certezza statistica.

Fermo restando che la certezza statistica non esiste, ma solo un’alta probabilità, bisogna calcolare questa probabilità. Il che equivale a dire: accorciare il più possibile l’intervallo di confidenza di tutte e due le varianti. Ossia, avere un numero di conversioni abbastanza elevato da essere certi di un risultato.

Se usi un software specifico per gli A/B test, sarà lui a dirti qual è il numero minimo di conversioni che è necessario raggiungere prima di poter concludere l’A/B test. Ma spesso questo non è possibile. Ad esempio, quando sto testando due pubblicità diverse in una campagna di Facebook Ads.

Anzitutto, quello che interessa a noi è il numero di conversioni, non di persone che hanno fatto il test. Quindi, se in un caso specifico servono 100 conversioni, si parla di 100 conversioni a prescindere dalle persone che hanno fatto il test senza convertire. Se il tasso di conversione è del 10%, allora servono 1000 persone totali. Se il tasso di conversione è 1%, ne servono 10.000.

Nel calcolo della probabilità statistica di un test, chi non ha convertito non conta.

La probabilità statistica si calcola in percentuale. Ad esempio, se ho il 90%, significa che “c’è il 90% di possibilità che la variante B sia migliore della variante A”. Non ci interessa sapere come calcolare questa percentuale: è una formula complessa (anche con la calcolatrice), ed esistono software che lo fanno al posto nostro.

Quante conversioni servono?

Il numero minimo di conversioni varia in base alla differenza nella percentuale di conversione delle due varianti.

Se la variante A ha un tasso di conversione del 3%, e la variante B del 9%, allora B converte il triplo di A. Basteranno poche conversioni per avere una certezza statistica del 95%. Se invece B ha una conversione del 3,2%, allora serviranno molte più conversioni per essere sicuri che sia migliore.

Se fai un test a occhio, il numero minimo da raggiungere è di almeno 30 conversioni per variante. Quindi se fai un A/B test con 2 varianti, almeno 60 conversioni in tutto. Con meno di 30 conversioni, si sta tirando a indovinare.

Tuttavia, 30 conversioni hanno senso solo se la differenza nella conversione è immensa. Quasi sempre servono almeno 100 conversioni per variante, se non di più.

O ancora meglio, usa un calcolatore apposta che calcoli la probabilità statistica: ne puoi trovare uno a questo indirizzo (in inglese). Inserisci il numero di visitatori totale, e il numero di conversioni per le due varianti. Il software ti dirà:

- La percentuale di conversione per ogni variante.

- Di quanto (in percentuale) una variante è superiore all’altra.

- La percentuale di probabilità statistica.

Per avere una buona statistica, dovresti avere sempre almeno il 95% di certezza. Per test molto importanti, dove serve la precisione assoluta, punta al 99%. Potrebbero servire settimane, forse mesi, ma non scendere mai sotto a un 95% di certezza. E in ogni caso, aspetta sempre almeno 30 conversioni per variazione.

In tutti i software dedicati di A/B test, c’è una voce che calcola automaticamente la percentuale di certezza.

Durata minima di un A/B test

Oltre alla percentuale di certezza, devi valutare la durata minima temprale di un test. Non ti preoccupare, questo è molto più semplice!

Per i test più semplici e meno importanti, la durata minima è di una settimana. Occhio però, con una settimana potresti avere dei falsi positivi. Se il test è importante, allora il minimo è 4 settimane.

Se il risultato del test ha il potenziale di cambiare drasticamente l’intera azienda, allora vuoi una certezza assoluta: punta a un test di almeno 6 settimane, e una certezza superiore al 99%.

Regressione alla media

Il fenomeno di regressione alla media è quello che ci dice che la maggior parte degli A/B test non ottengono un risultato significativo, e che gli inesperti stanno in realtà vedendo dei falsi positivi.

All’inizio di un test, dopo i primi giorni è normale vedere che una variante sia “meglio” dell’altra. I dati sono inconfutabili: 35% di miglioramento, 90% di certezza. Molti si fermano qui, chiudono l’esperimento, e implementano (o scartano) una modifica.

Tuttavia, basta aspettare qualche settimana per vedere che il margine si riduce piano piano, fino a sparire. Cosa succede?

Questo è il fenomeno della regressione alla media.

È la ragione per la quale i test dovrebbero durare almeno 4 settimane: nei primi giorni, è naturale vedere uno scarto sensibile, e un vincitore sembra emergere. Succede quasi sempre. Solo con il passare del tempo, e la riduzione del margine di errore, si può arrivare a trarre delle conclusioni.

Il mio consiglio: non guardare nemmeno il risultato di un A/B test prima che sia passata una settimana: sono dati inutili. Dopo 7 giorni, guarda un primo risultato solo per verificare che non ci siano errori. Ma se l’A/B test è importante, continua a farlo andare.

Aspetta 4 settimane, e solo allora potrai vedere cambiamenti statisticamente significativi.

Quindi: occhio ai falsi positivi, all’inizio molti test ti danno un vincitore fasullo, ma il divario tende ad annullarsi dopo qualche settimana.

Ascolta i dati, non l’istinto

Molti imprenditori si vantano di avere un “sesto senso”, un “istinto” quando si tratta di decisioni aziendali e sul proprio sito web.

Ci sono alcuni ambiti in cui avere un buon “naso” aiuta, ma non negli A/B test. Se segui il tuo istinto nel decidere il vincitore, allora tanto vale non sprecare nemmeno tempo a crearlo il test.

Spesso sento dire cose del tipo: “questo risultato è in linea con quello che mi aspettavo, quindi il test è finito!” Ma magari, il test ha 10-15 conversioni per variante. Questo non è un A/B test, è il lancio della monetina.

Equivale letteralmente a dire “ho lanciato la moneta ed è venuto croce come mi aspettavo, quindi non provo nemmeno a fare altri lanci, perché tanto so che uscirà sempre croce”.

Non bisogna mai, mai affidarsi al proprio istinto, o ai propri preconcetti, quando si fa un A/B test: è la strada più veloce per il fallimento. Aspetta di rispettare i requisiti qui sopra, e di avere una vera certezza statistica.

4 – Non smettere mai di testare

Il bello degli A/B test è che sono a basso rischio. Costa poco farli, sia in termini monetari che di tempo. Quindi non c’è ragione di non farne il più possibile.

In ogni momento, dovresti avere almeno 3-4 A/B test per ogni sito. Uno per l’opt-in, uno per la pagina di vendita, e uno per il carrello sono il minimo indispensabile. Se fai pubblicità, fai almeno un A/B test anche su quella.

Se il tuo sito web è particolarmente visitato, puoi ridurre il rischio di una variante che peggiore la conversione, allocando alla variante nuova solo una parte del traffico. Ad esempio, puoi dare il 70% di traffico alla pagina originale, che ha una buona conversione, e solo il 30% alla variante più rischiosa.

Questo allunga un po’ i tempi per raccogliere i dati, ma se non vuoi rischiare troppo, è una strada percorribile.

Il punto è che con la disarmante facilità e velocità degli A/B test, non c’è ragione per non farne il più possibile. Sono un metodo scientifico per migliorare un sito web, quindi andrai con il tempo a far crescere il tuo business in diversi ambiti.

Come creare un A/B test in 5 fasi

Ora che abbiamo capito la teoria che sta dietro agli A/B test, passiamo alla pratica.

Potresti pensare, dopo aver letto fino a qui, che sia difficile condurre uno di questi test. Per fortuna, non è così.

La parte difficile, negli A/B test, è schivare gli errori. Per questo motivo abbiamo speso così tanto tempo a parlare di come eliminare le variabili esterni, e di come avere un dato statisticamente significativo.

Ora che la parte difficile è andata, andiamo a vedere nella pratica cosa devi fare.

1 – Fai una lista di ipotesi

Il punto di partenza sono delle ipotesi, ossia delle domande o assunzioni che fai riguardo al tuo business e agli elementi che aiutano la conversione. Alcune di queste domande o assunzioni possono essere:

- Converte meglio il testo o il video?

- È meglio usare bottoni blu o rossi?

- Quale di queste caratteristiche prodotto interessa di più ai visitatori?

- Penso che cambiare il titolo della pagina possa migliorare le conversioni.

Il punto è che non devi fare A/B test a caso, ma devi prima fare delle ipotesi. Chiediti:

- Quale modifica voglio fare?

- Perché penso che questa modifica migliorerà la conversione?

Se non sai rispondere alla seconda domanda, non ha senso fare un A/B test: probabilmente darà un risultato inconclusivo.

Ad esempio, perché dovrebbe essere meglio un bottone rosso rispetto a quello blu che già uso? Se non lo so, non ha senso testare.

Se invece dico: “il bottone rosso converte meglio perché è più visibile, mentre quello blu si mimetizza nel template”, allora ha un senso.

La maggior parte degli A/B test fatti al mondo non danno risultati, e regrediscono alla media: la ragione è che chi li crea, non formula delle ipotesi ma si limita a testare a caso.

2 – Chiediti quale sia il test più importante

Un test prende di solito almeno 4 settimane per restituire dei dati. Puoi fare solo un test alla volta per pagina, quindi hai un grande costo-opportunità: se stai facendo un test, significa che non ne puoi fare un altro.

Se scegli un A/B test sbagliato, uno che è destinato a non dare risultati significativi, stai sprecando il tuo tempo. È come non testare, e modifiche importanti verranno rimandate a test successivi, facendo perdere fatturato all’azienda.

Una volta che hai delle ipotesi, fatti una serie di domande per capire quale testare prima. L’ipotesi che ha più “sì” è quella che dovresti testare prima:

- È un test su tutta la pagina?

- Il cambiamento è above the fold (parte alta della pagina)?

- Il visitatore può notare il cambiamento entro 5 secondi?

- Sto aggiungendo o rimuovendo un elemento?

- Sto cambiando la percezione del cliente nel brand?

- È su una pagina ad alto traffico?

- Risolve un problema rilevato nell’analisi qualitativa?

- È un’ipotesi supportata da esperimenti di mouse tracking?

- È facile da implementare?

3 – Crea un obiettivo

Il prossimo passo è creare un obiettivo, o conversione.

Per la maggior parte dei test, la conversione è la visita di una certa pagina, la “thank you page” che le persone vedono dopo l’acquisto del prodotto ad esempio. Ma non è sempre così.

Ci sono A/B test che possono valutare il bounce rate, quindi qualsiasi click o azione sul sito è considerata conversione. O durata media della visita: se una persona sta più tempo sul mio sito web (o guarda il video) quando faccio una modifica.

La partenza resta sempre l’ipotesi che hai fatto nel punto precedente. Chiediti: qual è il miglior modo di testare l’ipotesi? Qual è il miglior obiettivo che posso usare per verificarla?

Spesso la conversione è una pagina, ma non sempre. Se hai un ecommerce ad esempio, è molto più importante sapere il valore medio di ogni acquisto, o il valore medio per visitatore, non tanto il tasso di conversione.

4 – Esegui il test

Questa è la parte che abbiamo visto.

Apri il software che usi per fare un A/B test (ne parlo qui sotto), crea le varianti, imposta l’obiettivo (conversione), e fai partire il test. Ricordati di aspettare finché i dati non sono statisticamente significativi.

5 – Analizza il test

Una volta concluso il test, c’è ancora del lavoro da fare: l’analisi.

Un A/B test non serve solo a implementare cambiamenti, ma soprattutto a imparare una lezione.

Stabilisci un vincitore e implementa il cambiamento

Sarà il software a scegliere un vincitore, una volta passato abbastanza tempo e con una confidenza di almeno il 95%.

Qui tu non devi fare niente, ed è la parte più difficile: non stabilire un vincitore prima che lo dica la statistica. Ho ripetuto più volte questo concetto, perché la maggior parte delle persone commette un errore proprio qui.

Stabilito il vincitore, implementa un cambiamento se necessario. Se la variante B è meglio dell’originale, cambia l’originale per rispecchiare il cambiamento. Se l’originale è ancora la migliore, scarta la variante.

Estrapola una lezione da imparare

Il risultato di un A/B test è utile solo quanto la lezione che impari da esso.

Se ricordi, tutto parte da un’ipotesi: ti fai una domanda riguardo ai tuoi visitatori e come interagiscono col sito web, e fai un A/B test per rispondere a questa domanda.

Ora è il momento di rispondere alla domanda, e imparare una lezione. Ad esempio:

- Il bottone rosso è più efficace: significa che i bottoni con CTA importanti devono risaltare, essere di un colore subito visibile.

- Il nuovo titolo converte di più: perché? Cos’ha di diverso?

- La nuova immagine converte di più: in cosa è diversa? Perché ha più appeal?

Idealmente, alla fine di uno A/B test, devo avere imparato qualcosa in più sui miei visitatori. Sul modo in cui navigano il sito web. Questo rende gli A/B test più utili della semplice ottimizzazione facendo modifiche casuali, nella speranza che vadano bene.

Per questo servono le ipotesi: se parto da quelle, alla fine del test avrò estrapolato una lezione importante che posso implementare anche in altri ambiti.

Cerca di trovare vari segmenti

Come detto sopra, è difficile eliminare tutte le variabili esterne. Sono tante, confusionarie, e casuali. Ma posso analizzare i dati successivamente alla conclusione del test per dividere in segmenti.

Ad esempio, ho fatto un A/B test su visitatori che vengono da varie fonti: organico, Facebook, pubblicità. Dopo 4 settimane, ho trovato la variante che converte di più.

Ora vado su Google Analytics (o simile) e filtro una per volta ogni fonte di traffico.

Se considero solo il traffico organico, quale variante vince? E col traffico Facebook? E con quello pubblicitario?

Qui sono alla ricerca di grossi sconvolgimenti nel risultato. Se vedo che per il traffico organico un’altra variante, perdente nell’A/B test globale, è la migliore, può essere una buona idea fare un nuovo A/B test unicamente sul traffico organico.

Ecco altre segmentazioni che puoi provare:

- Traffico desktop e mobile.

- Traffico email.

- Nuovi visitatori e visitatori che tornano (return traffic).

- Acquirenti e non acquirenti.

- Provenienza da diversi articoli o sezioni del blog.

Condividi i risultati

Se sei in un’agenzia che ha diverse persone al suo interno, non puoi tenere i risultati dell’A/B test per te: devi condividerli.

Attenzione però, non condividere i numeri nudi e crudi: condividi la lezione che hai imparato, la risposta che hai dato all’ipotesi. Solo in seguito, se qualcuno lo chiede, puoi fornire i dati.

L’idea è che le ipotesi sono domande che ci si fa riguardo al cliente, e capire un po’ meglio il cliente è importante per molti dipartimenti aziendali, non solo per te. Quindi ogni volta che impari qualcosa di nuovo grazie a un A/B test, dovresti condividerlo con tutti.

Idee per il tuo primo A/B test

In molti cercano online articoli del tipo: “99 idee per il tuo primo A/B test”.

Queste cose non hanno senso. Ogni azienda ha esigenze diverse, e ipotesi diverse. Gli A/B test non sono il fine ultimo, sono un mezzo per testare le tue ipotesi. Quindi prima fai un’ipotesi, una domanda, poi crea un A/B test ideale per avere una risposta.

Alcuni esempi di elementi da testare sono:

- Navigazione

- Titolo

- Immagini

- Colori

- Lunghezza

- Video

Ma non limitarti lista. È per forza di cosa incompleta, e non modellata intorno al tuo business e alle tue ipotesi. Solo tu puoi sapere quali siano gli A/B test migliori da fare sul tuo sito.

A/B test via email

Oltre al sito web, è comune fare A/B test sulle proprie email. Ad esempio, per capire quale oggetto porti a più aperture e click in totale. Questa è una funzione supportata da tutti i maggiori autoresponder: puoi vedere il tutorial su come farlo con ActiveCampaign su questa pagina.

Tuttavia, potresti non accontentarti dell’A/B test sulle singole email. Vuoi testare funnel interi, quindi sequenze di email.

Ad esempio, vuoi vedere se è meglio mandare email ogni giorno, o ogni 2 giorni. O se è meglio proporre un prodotto alla terza o quarta email. In quel caso, la maggior parte dei software di email marketing non offrono questa funzione.

Grazie alla nuova funzionalità di A/B test sulle automazione di ActiveCampaign, ora puoi portare questa potente funzionalità fuori dal sito web o dalle email singole, e iniziare a implementare gli A/B test per verificare quale funnel sia il migliore.

Puoi leggere di più su questa funzionalità a questo indirizzo.

Software consigliati

E ora, passiamo alla parte finale: i software per fare A/B test sul sito web.

Non ci si scappa, non si può fare A/B test senza un software apposito. Questo perché, oltre alla parte analitica, serve qualcosa che divida in maniera casuale gli utenti fra le due o più varianti. Se poi voglio fare un test multivariato, allora un software che lo gestisca è indispensabile.

Ho diviso i software in due categorie: a pagamento e gratuiti.

Optimizely e Visual Website Optimizer

Questi due sono i software a pagamento per A/B test più diffusi sul mercato.

Supportano tutti i tipi di test (compresi multivariati), segmentazione, e hanno una reportistica avanzata oltre che un editor visuale. L’editor visuale permette di creare variazioni di una pagina web al volo, senza dover creare una pagina web separata: un grande risparmio di tempo.

Oltre a questo, permettono di calcolare non solo la conversione, ma anche la revenue. Ossia, l’importo medio di un acquisto: indispensabile per e-commerce con esigenze avanzate di A/B test.

Tutti e due i software hanno anche le heatmap, ovvero la mappa delle zone più visualizzate e cliccate dagli utenti: una funzione utile per analizzare più in dettaglio le pagine, che altrimenti dovrebbe essere integrata con un altro software a pagamento.

Non posso dare un giudizio su quale sia il miglior software, perché varia a seconda delle preferenze personali. Io mi sono trovato bene con Visual Website Optimizer, ma so che in molti preferiscono Optimizely.

Il mio consiglio, se sei disposto a pagare dai 30 ai 55€ al mese per gli A/B test, di provarli gratis tutti e due per decidere quale faccia per te.

Google Optimize

Questo è un nuovo strumento di Google, che va ad affiancarsi al già presente Google Experiments.

Il suo vantaggio, oltre ad essere 100% gratuito, è che si integra alla perfezione con Google Analytics: se già lo usi, allora ti darà una miriade di dati che gli altri software non possono fornirti. Questo, da solo, può essere un vantaggio competitivo inestimabile per chi sa leggere questi dati.

Tuttavia, Optimize non ha tutte le funzioni dei due software a pagamento.

Si possono fare A/B test con editor visuale, e test multivariati. Ma non si può tracciare il guadagno medio per ordine, e non ci sono le heatmap (per quelle, io mi affido comunque all’ottimo Hotjar).

L’interfaccia, così come tutti i prodotti Google, è scarna e oggettivamente un po’ limitata. Un prodotto fantastico per chi vuole iniziare con gli A/B test, e ancora non se la sente di pagare per un software dedicato. Ma essendo più limitato degli altri, i siti web più grossi e con esigenze particolari potrebbero sentire la mancanza di certe funzioni.

Conclusione

Se all’inizio di questo articolo a mala pena sapevi cosa fosse un A/B test, ora sei un esperto dell’argomento.

Capisco che questo sia un argomento complesso, soprattutto per le persone che non digeriscono la matematica. Ma una volta compresi i principi fondamentali, è di una facilità disarmante:

- Fai durare un test almeno 4 settimane.

- Aspetta 100 conversioni per variazione, e una certezza del 95%.

- Usa dei software per aiutarti a calcolare il vincitore.

- Fai sempre delle ipotesi prima di testare.

- Analizza ogni risultato per imparare delle lezioni.

- Cerca di eliminare tutte le variabili esterne.

- Non farti influenzare dalla tua opinione o “sesto senso”.

Segui questi principi, e sarai sulla buona strada per fare degli A/B test utili, statisticamente validi, che danno un aiuto concreto al tuo business.

[MIO] Il futuro dell'email marketing: il tracciamento web - Active Powered

30/05/2017 @ 18:39

[…] Abbiamo già scritto e parlato dello Split-Testing, quindi se vuoi capire come farlo nella pratica ti rimando a questo indirizzo. […]

I migliori software e app per imprenditori digitali - Active Powered

12/03/2021 @ 11:28

[…] split test (o A/B test) sono più complessi di quello che credi, ma sono molto importanti per ottimizzare il tuo funnel. Dovresti sempre avere uno split test in […]

Cos'è un'infografica e come crearla - Active Powered

03/05/2021 @ 08:00

[…] clienti, considera l’idea di sponsorizzarla, alternandola con una inserzione classica, in un A/B test per vedere la differenza in termini di riscontro. Secondo il Blog di Marketing […]

Email marketing per personal trainer. Strategie e strumenti - Active Powered

20/09/2023 @ 07:00

[…] test A/B per ottimizzare oggetti, contenuti e call-to-action delle tue email. Questo ti aiuta a scoprire […]

7 Errori da evitare quando fai email marketing automation - Active Powered

25/10/2023 @ 10:20

[…] sia un A/B test, o che sia un test più complesso, quello che non deve mancare mai nel team marketing è […]